Kubernetesは豊富なオートスケーリングツールのエコシステムを提供していますが、それらを使いこなすことは迷路を歩くような感覚かもしれません。すでにKubernetesオートスケーリング101を読んだり、Kubernetesスケジューリング戦略を探索したことがあれば、主要なオートスケーラーの比較についてより深く掘り下げる準備ができているでしょう。

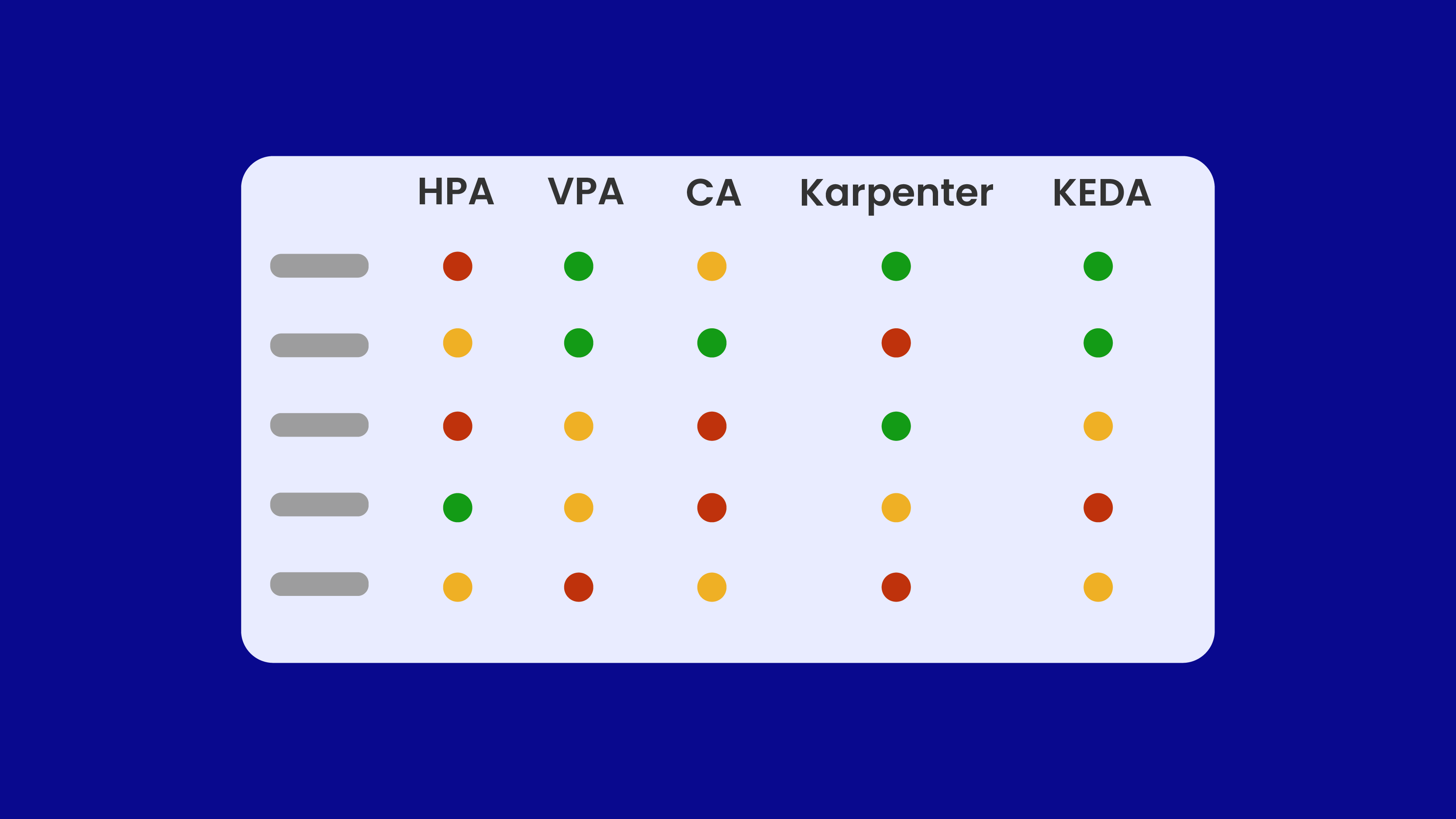

この記事では、Kubernetesオートスケーリングツールボックスの5つの主要ツールを比較します:

- Horizontal Pod Autoscaler (HPA)

- Vertical Pod Autoscaler (VPA)

- Cluster Autoscaler (CA)

- Karpenter

- KEDA (Kubernetes Event-driven Autoscaler)

これらのツールの目的、違い、制限、実際のユースケースを理解し、ワークロードに最適な選択ができるようサポートします。

Kubernetesにおけるオートスケーリングの次元

ツールを比較する前に、オートスケーリングの主要な次元を区別することが重要です:

- ポッドレベルのスケーリング: ワークロードの需要に基づいてポッドレプリカの数を調整します。

- リソースレベルのスケーリング: 実際の使用状況を反映するためにポッドリソース要求(CPU、メモリ)を調整します。

- クラスターレベルのスケーリング: 集約リソース需要を満たすためにノードの数とタイプを調整します。

- イベント駆動型スケーリング: キューの長さやジョブのバックログなどの外部メトリクスに基づいてスケーリングします。

これらの層をすべて包括的に対応する単一のツールはありません。以下のセクションでは、各コンポーネントの技術的能力とトレードオフを分析します。

要約:比較マトリックス

| 機能 | HPA | VPA | Cluster Autoscaler | Karpenter | KEDA |

|---|---|---|---|---|---|

| ポッドスケーリング | ✅ | ❌ | ❌ | ❌ | ✅ |

| リソース調整 | ❌ | ✅ | ❌ | ❌ | ❌ |

| ノードスケーリング | ❌ | ❌ | ✅ | ✅ | ❌ |

| 外部メトリクスによるスケーリング | ✅ (API経由) | ❌ | ❌ | ❌ | ✅ |

| HPAとの連携 | N/A | ⚠️ 非推奨 | ✅ | ✅ | ✅ |

| VPAとの連携 | ⚠️ CPU/メモリで競合 | N/A | ✅ | ✅ | ✅ |

| 反応時間 | 中程度(15秒間隔) | 遅い(数分) | 遅い(数分) | 速い(リアルタイム) | 速い(ポーリング依存) |

| ステートフルワークロードのサポート | 部分的 | あり | あり | あり | なし |

| コスト最適化機能 | なし | 間接的(調整による) | 部分的 | あり(スポット、ビンパッキング) | 間接的 |

Horizontal Pod Autoscaler (HPA)

Horizontal Pod Autoscalerは、CPU、メモリ使用率、またはカスタムアプリケーションレベルのシグナルなどの観測されたメトリクスに基づいて、ポッドレプリカの数を自動的に調整します。

これはkube-controller-manager内で制御ループとして実行され、デフォルトで15秒間隔でメトリクスをポーリングします。この間隔は--horizontal-pod-autoscaler-sync-periodフラグを使用してカスタマイズできます。

HPAはメトリクスサーバーまたはカスタムメトリクスAPIに依存し、次の式を使用して必要なレプリカ数を計算します:

desiredReplicas = ceil(CurrentReplicas × (CurrentMetric / TargetMetric))。

CPUやメモリの負荷が変動するステートレスサービスに適しており、外部メトリクスとの統合をサポートしています。

ただし、HPAはポッドのリソース要求を変更せず、これはVertical Pod Autoscalerによって処理されます。また、インフラストラクチャをプロビジョニングせず、ワークロードをゼロにスケールすることもできません。変動の激しい環境では、急速なスケールイン/スケールアウトのサイクルを避けるためにチューニングが必要な場合があります。

Vertical Pod Autoscaler (VPA)

Vertical Pod Autoscalerは、過去の使用状況を分析することでポッドのリソース要求を時間の経過とともに調整します。以下の3つのコンポーネントで構成されています:

- Recommender:使用状況データを分析し、リソース推奨事項を生成

- Updater:ポッドを退去させ、更新された要求でのスケジューリングを再トリガー

- Admission Controller:ポッド作成時に推奨事項を注入

VPAは推奨のみモードと強制モードの2つをサポートしています。強制モードでは、リソース値が変更されるとポッドが自動的に再起動され、本番環境では中断を引き起こす可能性があります。メトリクスはコンテナ使用量ヒストグラムを使用して収集されます。

これは、バッチジョブやメモリを多用するアプリケーションなど、安定した予測可能な使用パターンを持つワークロードに適しています。過剰なプロビジョニングを排除し、CI/CDパイプラインでリソースの適正化によく使用されます。

ただし、VPAはレプリカのスケーリングやインフラストラクチャ管理を処理しません。HPAと併用する場合は、CPUなどの共有メトリクスで競合が発生しないよう注意が必要です。

Cluster Autoscaler (CA)

Cluster Autoscalerは、ポッドがスケジュールできない場合にノードを追加し、十分に活用されていないノードを安全にドレインできる場合に削除することで、Kubernetesクラスターのサイズを調整します。直接的な使用メトリクスは使用せず、スケジューリングの失敗に反応します。

AWS Auto Scaling GroupsやGCP Managed Instance Groupsなどのクラウドネイティブなノードグループ抽象化と統合されています。デフォルトのスケールダウン遅延は10分で、設定はワークロードパターンに合わせて調整できます。PodDisruptionBudgets、テイント、ラベルを尊重します。

CAはマネージドKubernetesサービスで広く使用されており、HPAとの相性も良いです。ただし、事前定義されたノードグループが必要であり、インスタンスタイプを動的に選択する柔軟性に欠けます。そのスケールアップの判断は意図的に保守的であり、混合ワークロードを持つクラスターではフラグメンテーションが一般的です。

Karpenter

Karpenterはクラスターオートスケーラーの最新の代替品で、静的に定義されたノードグループに依存せずに、高速で柔軟なノードプロビジョニングを実現するように設計されています。スケジュールできないポッドを監視し、AWS EC2 CreateFleetなどのクラウドAPIを通じて適切なコンピューティングリソースを起動することでリアルタイムに対応します。

Karpenterはカスタムリソース定義(NodeClassとNodePool)を導入し、インスタンスタイプ、アーキテクチャ、キャパシティタイプ(スポットまたはオンデマンド)、アベイラビリティゾーンなどのプロビジョニング戦略を定義します。コスト効率とトポロジー対応の配置を重視し、ノードの統合やドリフト検出などの機能も含まれています。

クラスターオートスケーラーと比較して、Karpenterははるかに高速なプロビジョニングと大きな柔軟性を提供します。スポットインスタンスの使用、リアルタイムのビンパッキング、カスタムスケジューリング制約をサポートしています。ただし、組み込みの予算管理機能がなく、メトリックベースのしきい値を使用せず、スケジュールできないポッドのシグナルのみがプロビジョニングをトリガーします。

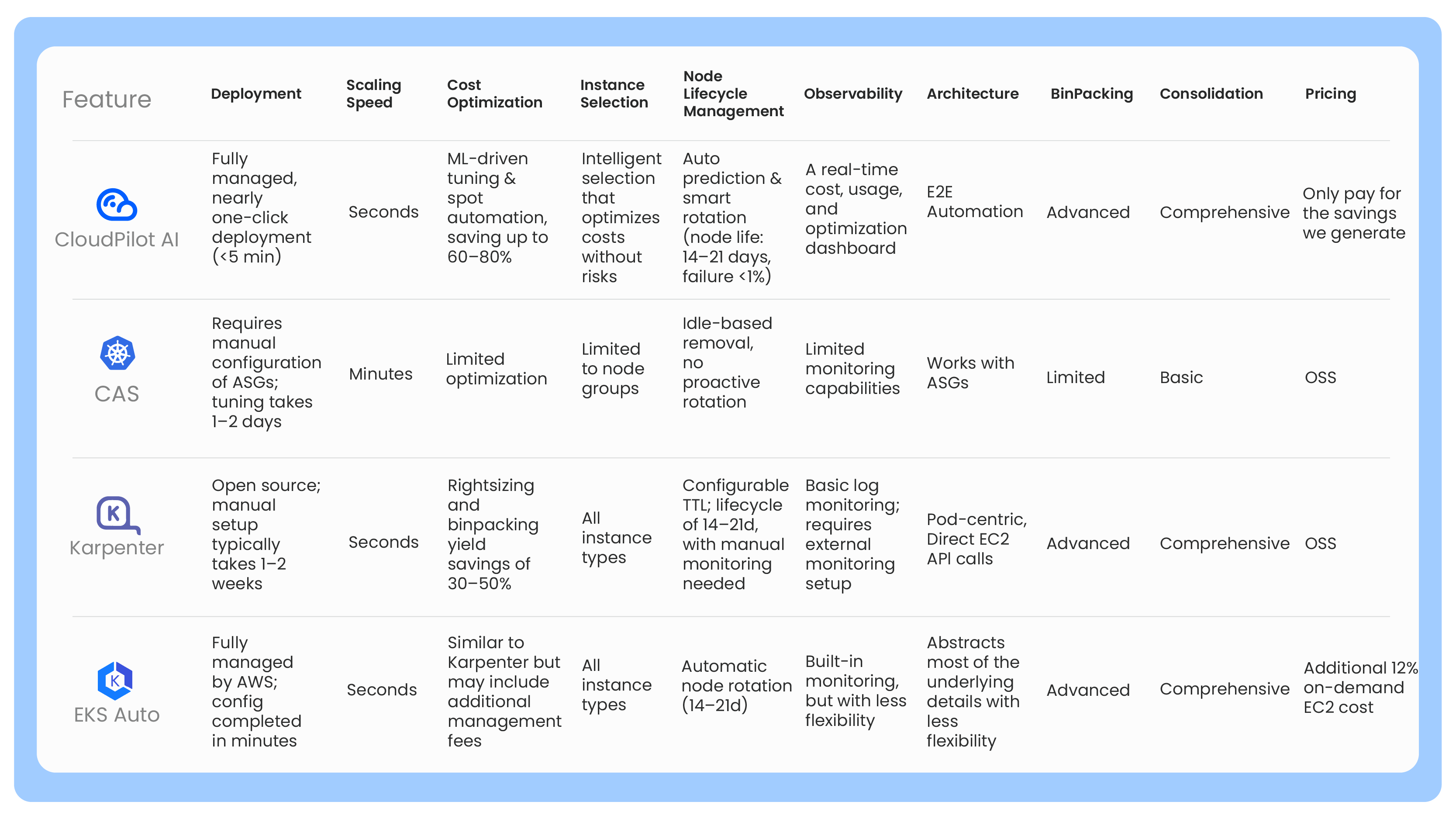

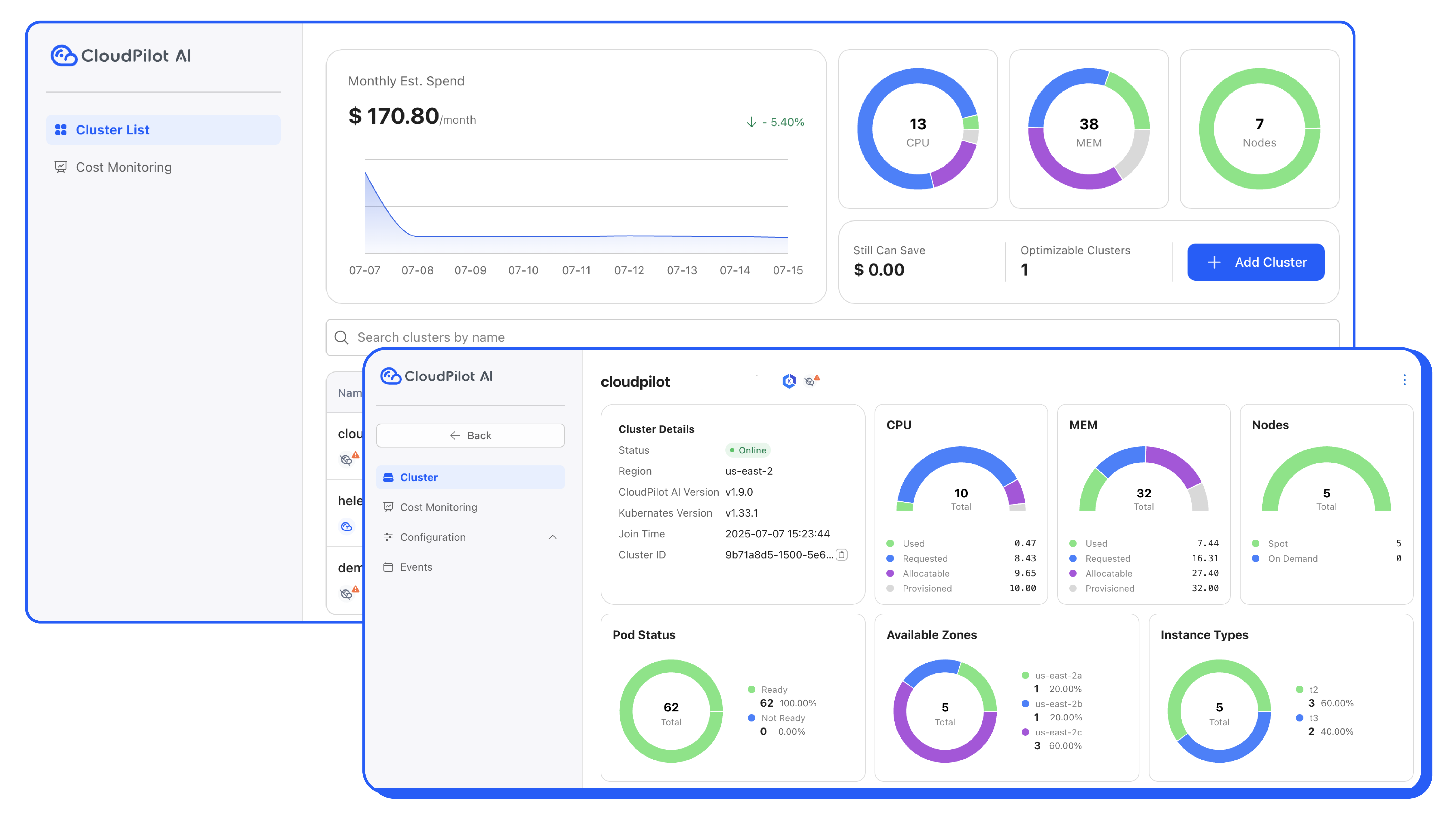

CloudPilot AIでKarpenterを使用する

Karpenterはノードプロビジョニングに柔軟性とスピードをもたらしますが、過去の価格傾向、リアルタイムのスポット中断予測、またはコスト主導のプロビジョニングポリシーを考慮していません。

ここでCloudPilot AIがKarpenterベースのセットアップを強化します。Karpenterのプロビジョニング決定と直接統合することで、CloudPilot AIは以下を提供します:

- 45分間の中断予測に基づくインテリジェントなスポットインスタンス選択

- アベイラビリティゾーンとインスタンスタイプ全体の過去の価格

- ワークロードごとに設定可能なカスタムコストと信頼性のトレードオフ

- ノードの入れ替わりを減らすための不安定または急激な市場のリアルタイム回避

Karpenterを実行しているチームは、CloudPilot AIを使用することで、プロビジョニングの決定が適合性と速度だけでなく、コスト、信頼性、可用性のバランスを確保できます。その結果、特にスポットで実行される本番クラスターにおいて、クラウド効率が大幅に向上したよりスマートなKarpenterセットアップが実現します。

KEDA、Kubernetes イベント駆動型オートスケーラー

KEDAは、CPUなどの内部メトリクスではなく、外部またはイベント駆動型の信号に基づいてオートスケーリングを可能にします。これらの信号には、キューの深さ、リクエスト率、または時間ベースのスケジュールが含まれる場合があります。KEDAは、トリガーを定義しワークロードにリンクするScaledObjectとScaledJobリソースを導入しています。

Kafka、Redis、Prometheus、AWS SQSなどのシステム向けに50以上の組み込みスケーラーをサポートしています。KEDAはこれらのシステムをポーリングし、Kubernetes APIにメトリクスを公開することで、HPAがそれらを消費できるようにします。イベント駆動型マイクロサービスやジョブキューに不可欠な、ワークロードをゼロからおよびゼロへスケーリングすることができます。

KEDAはCI/CDワークフローやステートレスワークロードとうまく統合されます。反応的で軽量ですが、インフラストラクチャやノードのプロビジョニングは管理しません。その応答性はポーリング間隔に依存し、スケーラーは各環境に対して安全に構成する必要があります。

実世界のパターン

本番環境では、オートスケーラーが単独で使用されることはほとんどありません。以下は、多くのSREおよびDevOpsチームが採用している実用的な組み合わせです:

1. ステートレスウェブサービス

CPUまたはレイテンシに基づいてスケーリングするためにHPAを使用し、リアルタイムのノードプロビジョニングとコスト意識のあるスケーリングのためにKarpenterと組み合わせます。CloudPilot AIはこれをさらに進め、スポットインスタンスの自動化、中断の予測と管理、安定したスポットプールの選択、必要に応じてオンデマンドへのフォールバックを処理します。

2. バッチジョブとMLパイプライン

リソース要求を微調整するために推奨モードでVPAを実行し、Karpenterが各実行に最適なコンピュートタイプをプロビジョニングします。CloudPilot AIは800以上のインスタンスタイプにわたるインテリジェントな選択でこのパターンを強化し、短命、バースト、またはGPU重視のワークロードに対してコスト効率の高いコンピュートを自動的に選択します。

3. キューベースのワーカー

KEDAを外部メトリクス用スケーリングとして使用し、Karpenterと組み合わせることで、スポットインスタンスまたはオンデマンドノードによる突発的な需要に対応できます。CloudPilot AIは、起動時間が最小限で信頼性の高いノードを自動的に選択することで、このバーストスケーリングに確実性を加えます。

4. レガシーまたはマネージド環境

事前定義されたノードグループとより保守的なスケーリング動作が必要な場合は、HPAとCluster Autoscalerを併用します。

5. フラグメンテーションを伴うマルチテナントクラスター

マルチテナントプラットフォームや内部開発者プラットフォーム(IDP)では、リソースのフラグメンテーションが一般的です。ワークロードレベルのスケーリングにはHPA、制約を考慮したノードプロビジョニングにはKarpenter、そして未使用リソースを削減するための厳格なトポロジールールを使用します。CloudPilot AIは、ワークロードをリアルタイムで適切なインスタンスに知的にマッチングさせ、過剰プロビジョニングを最小限に抑え、クラスター全体のコストを削減する重要な役割を果たします。

結論

Kubernetesのオートスケーリングエコシステムは設計上モジュール式です。各ツールは、ポッド、リソース、インフラストラクチャ、または外部負荷など、異なるレイヤーに対応しています。本番環境グレードの信頼性とコスト効率を実現するには、組み合わせ可能なオートスケーリング戦略が不可欠です。

現在のスケーリング設定がHPAとCluster Autoscalerのみに依存している場合、効率性、回復力、コスト削減の機会を逃している可能性が高いです。CloudPilot AIはKarpenterのようなツールを補完し、スポットインスタンス管理を自動化し、800種類以上のインスタンスタイプから最適なノードを知的に選択することで、チームがよりスマートにスケールし、コストを削減できるよう支援します。

リソースのオートスケーリングについてのアイデアをお持ちですか?私たちのSlack/Discordインスタンスにメッセージを送ってください。あなたの経験を共有していただければ幸いです。

よくある質問(FAQ)

HPAとVPAを一緒に使用できますか?

簡単ではありません。両方がCPUやメモリのメトリクスに基づいて動作する場合、互いに干渉します。一方が使用率に基づいてポッド数を調整しようとする一方で、もう一方がリソース要求を調整しようとするため、不安定な動作につながります。HPAが外部メトリクスを使用し、VPAがCPU/メモリの強制を避ける場合に限り、限定的な組み合わせが可能です。

Karpenterはクラスターオートスケーラーに取って代わるものですか?

機能的には、ほとんどの動的環境においてはそうです。Karpenterはより速いプロビジョニング、スポットインスタンスのサポート、柔軟なノード形状の選択を提供します。ただし、現時点ではマルチクラウドサポートや、マネージドノードグループと連携する場合にCAが提供する予算管理機能が十分に成熟していません。

KEDAはサーバーレスやイベント駆動型アプリケーションにのみ有用ですか?

必ずしもそうではありません。KEDAはワークロードの量がCPUやメモリに関連していない状況—キューの長さ、HTTPトラフィック、cronスケジュールなど—で効果的に機能します。メトリクスベースのオートスケーラーだけでは達成できないスケーリングパターンを可能にします。

VPAはいつ使用すべきですか?

長時間実行されるワークロードやバッチワークロードを微調整するには、レコメンデーションモードでVPAを使用してください。エンフォースメントモードはリソース更新時にポッドの退避が発生するため、中断の影響が少ない環境向けに予約すべきです。

本番環境でこれらのツールをどのように組み合わせればよいですか?

典型的な本番環境のセットアップには以下が含まれます:

- ステートレスサービスのCPUベースのスケーリングにはHPA

- インフラストラクチャのプロビジョニングにはKarpenter

- ジョブやキュー駆動型アプリケーションにはKEDA

- レイテンシに敏感でないワークロードのリソース最適化にはVPA 各オートスケーラーはシステムの異なるレイヤーで動作し、慎重に設定すれば競合なく共存できます。