オートスケーリングとは?

Kubernetes オートスケーリングは、変化する需要に応じてクラスターが自動的にリソースを調整できる強力な機能で、パフォーマンスとコストの両方を最適化します。リアルタイムのメトリクスに基づいてノードやポッドを動的にスケーリングすることで、アプリケーションが適切なタイミングで適切なリソースを持つことを保証します。Kubernetesは3つの主要なタイプのオートスケーリングをサポートしています:

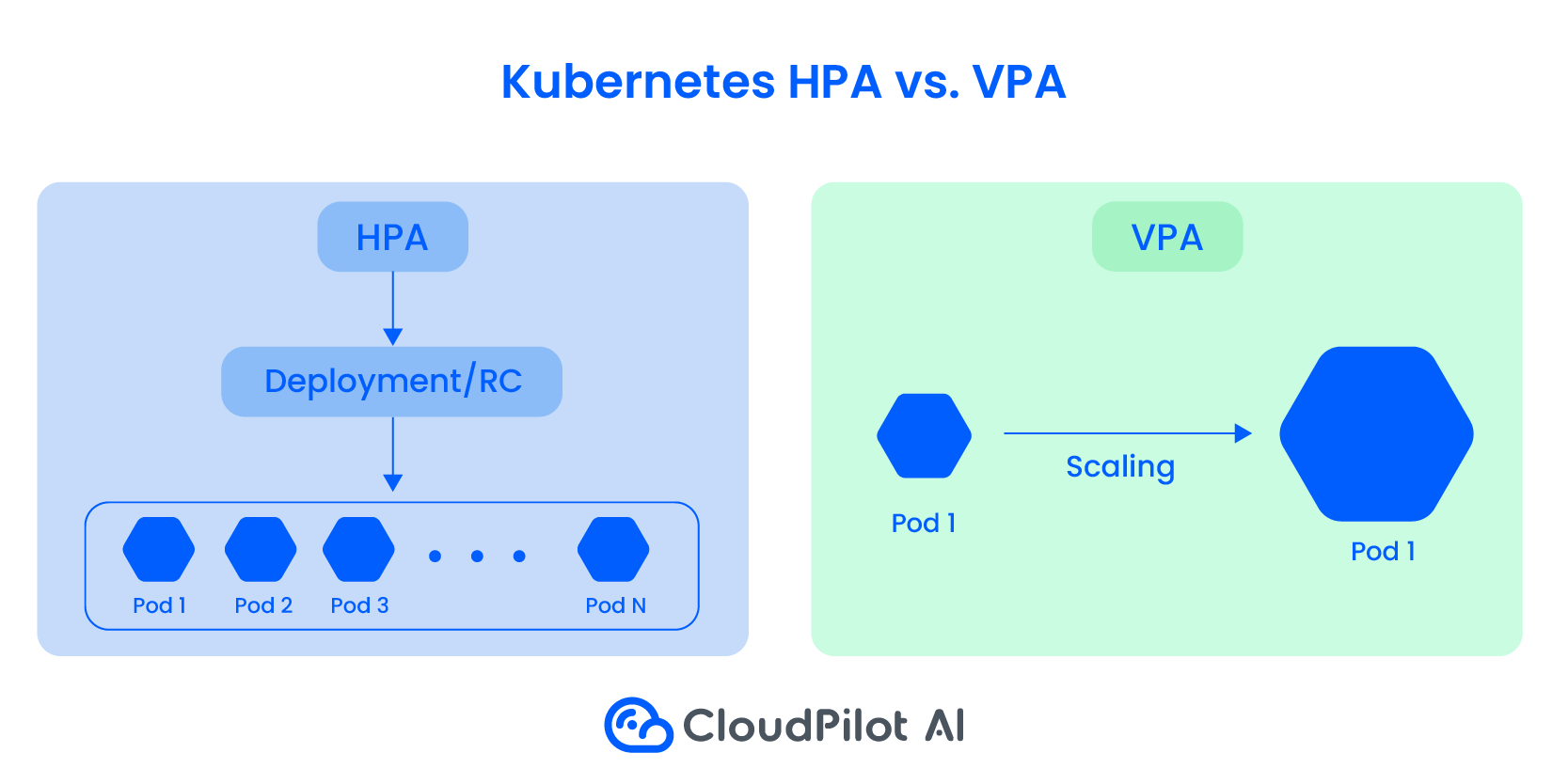

1. 水平ポッドオートスケーラー(HPA) はワークロードの需要に合わせてポッドのレプリカ数をスケーリングします。

2. 垂直ポッドオートスケーラー(VPA) は各ポッドのCPUとメモリの割り当てを微調整して、最適なリソース使用を確保します。

3. クラスターオートスケーリング はクラスター内のノード数を調整して、効率性とコスト効果を維持します。

これらのオートスケーリングメカニズムは連携して弾力的なスケーラビリティを提供し、信頼性とコスト効率のバランスを取ります。ただし、オートスケーリングを効果的に実装するには、クラスターの応答時間のバランス、適切なスケーリングトリガーの設定、水平スケーリングと垂直スケーリングの戦略の調和を確保して競合を避けるなどの課題に対処する必要があります。

Kubernetes オートスケーリングは、組織がリソースの無駄を最小限に抑えながら高いサービス可用性を維持できるようにし、現代のクラウドネイティブ環境に不可欠なツールとなっています。

Kubernetes オートスケーリングの3つの方法

水平ポッドオートスケーラー(HPA)

Kubernetesの水平ポッドオートスケーラー(HPA)は、変化するワークロード需要に応じてポッドのレプリカ数を動的に調整し、最適なリソース利用とアプリケーションパフォーマンスを確保します。HPAは継続的にCPUやメモリ使用量などのリアルタイムメトリクスを監視し、Kubernetesメトリクスサーバーを使用してスケーリングアクションが必要かどうかを評価します。

定義されたしきい値(CPUの使用率が70%を超えるなど)を超えると、HPAは自動的にポッドの数を増減して目標値を満たし、効率的なワークロード処理を確保します。

通常はCPUとメモリに焦点を当てていますが、HPAはネットワークトラフィックやキュー内の保留中タスク数などのカスタムメトリクスや外部メトリクスも活用でき、よりカスタマイズされたスケーリング戦略を可能にします。これはステートレスアプリケーションに特に適していますが、ステートフルワークロードのスケーリングも管理できます。

水平スケーリングは迅速な弾力的容量調整を可能にし、予測不可能なトラフィックスパイクを経験するアプリケーションには不可欠です。ただし、スケーリングできないDaemonSetsなどのオブジェクトには適用できません。クラスターオートスケーリングと組み合わせることで、HPAは動的なクラウド環境でパフォーマンスとコスト効率のバランスを取るための強力なツールとなります。

垂直ポッドオートスケーリング(VPA)

Kubernetesの垂直ポッドオートスケーラー(VPA)は、ポッドのCPUとメモリリクエストを自動的に調整し、リソース割り当てが実際の使用量と一致するようにします。

ポッドを追加または削除してスケーリングする水平ポッドオートスケーラー(HPA)とは異なり、VPAは個々のポッドのリソース制限の変更に焦点を当てています。これは、リソース需要の一時的な急増を経験するワークロードや、水平方向に簡単にスケーリングできないワークロードに特に役立ちます。

VPAは3つの主要コンポーネントを通じて動作します:

1. レコメンダー – 現在および過去のリソース使用率を継続的に監視し、最適なリソース制限を計算します。

2. アップデーター – 古いリソース構成で実行されているポッドを特定し、それらを退避させて更新された制限を適用します。

3. アドミッションコントローラー – 変更用ウェブフックを使用して、ポッド作成時に新しいリソースリクエストを注入します。

Kubernetesは実行中のポッドのリソース制限の変更をサポートしていないため、VPAは古い構成のポッドを終了し、コントローラーによってポッドが再作成されると、更新された制限が適用されます。また、「推奨モード」で実行することもでき、ポッドを終了せずに最適なリソース値を提案します。

VPAはCPUやメモリを無駄にすることなくリソース使用を最適化するのに理想的です。ただし、HPAと併用する場合は、両方が同じメトリクスに基づいてリソース割り当てに影響を与える可能性があるため、競合を避けるよう注意が必要です。調和を実現するために、HPAはカスタムメトリクスを使用し、VPAはCPUとメモリに焦点を当てることで、両方のオートスケーラーを効果的に連携させることができます。

クラスターオートスケーリング

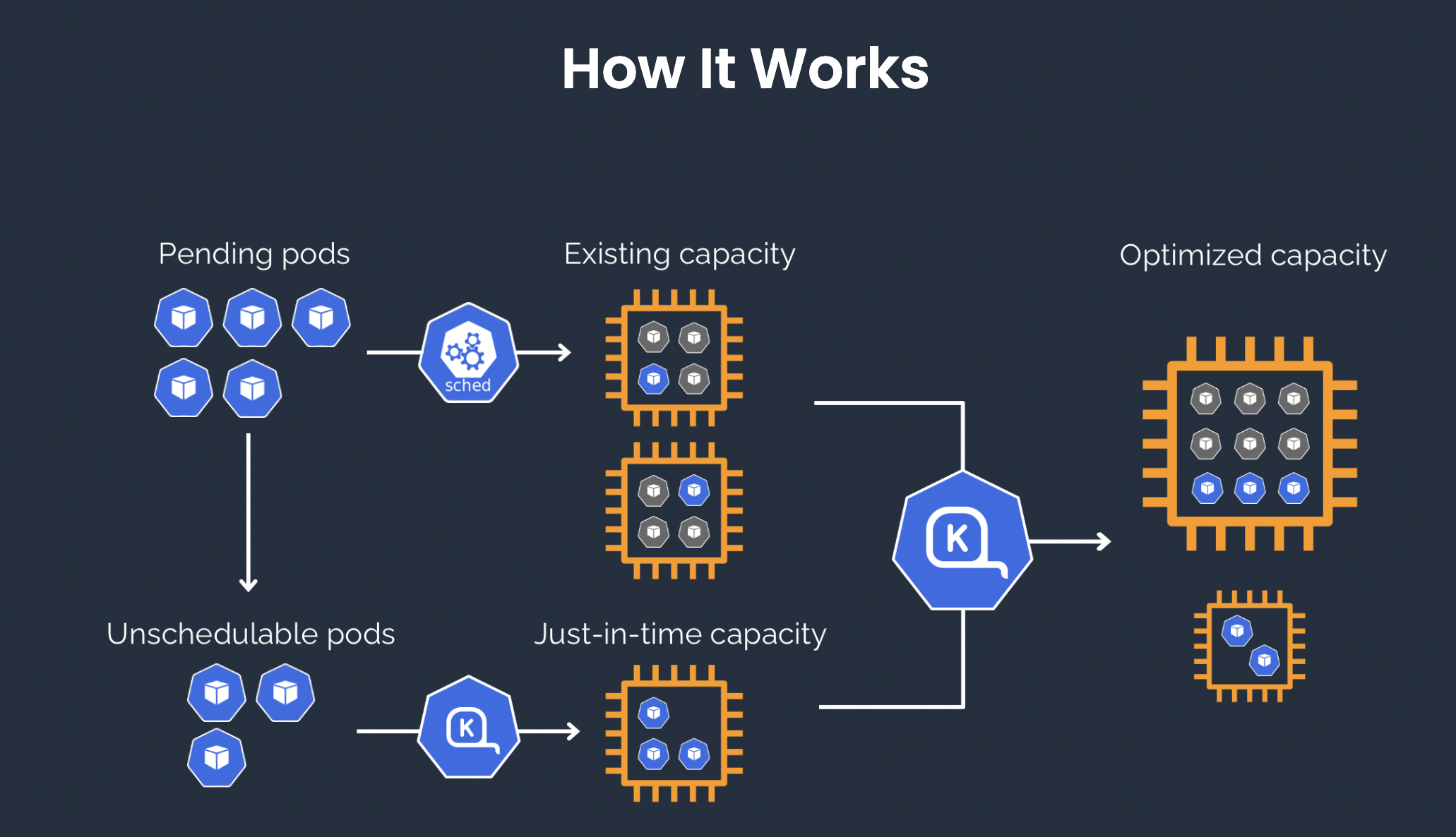

KubernetesのCluster Autoscaler(CA)は、ワークロードのリソース要件に合わせてクラスター内のノード数を動的に調整します。CPUやメモリの不足、または一致しないtaint許容とアフィニティルールによりポッドがスケジュールできない場合にノードを追加することで、リソースの効率的な使用を確保します。

逆に、可能な場合はポッドを他のノードに再スケジュールすることで、使用率の低いノードを削除します。この際、ポッドの優先順位とPodDisruptionBudgetsを考慮します。

オートスケーラーは次の2つの主要なタスクを継続的に繰り返します:

1. スケールアップ: スケジュールできないポッドを特定し、新しいノードを追加することで問題が解決するかどうかを確認します。解決する場合は、ノードプールのサイズを増やします。

2. スケールダウン: 既存のノードを統合の機会がないか調査します。ポッドが他の場所に再スケジュールできる場合、ノードはドレインされて終了され、スムーズな再スケジュールを確保するための猶予期間(通常10分)が設けられます。

Cluster Autoscalerはインフラストラクチャレベルで動作し、ノードの追加や削除を行うための権限が必要です。主にクラウドプラットフォームで使用され、最小権限の原則に従って安全な認証情報で構成する必要があります。

CAはノードスケーリングを自動化することで、コストを最適化し、ワークロード需要に対応するための十分な容量を確保し、アプリケーションの信頼性を維持しながら過剰なプロビジョニングを防ぎます。

検討すべきもう一つの重要なオープンソースツールは、Karpenter、高度なクラスターオートスケーラーの代替手段です。これは2023年にCNCFに寄贈され、AWS EKS、Microsoft Azure、Alibaba Cloud AKSをサポートし、クラウド機能を活用しながら高速でシンプルに使用することを目指しています。

Karpenterのクラスターオートスケーリングに対する革新的なアプローチは、Kubernetesクラスターが動的ワークロードを処理する方法を強化し、より速くスケーリングし、最適な結果を得るための手動設定を減らします。

1. 積極的なノード管理: 自動スケーリンググループ(ASG)に依存し、反応が遅くなる可能性がある従来のクラスターオートスケーラーとは異なり、Karpenterは直接ノードを管理します。これにより、数百のオプションから最適なインスタンスタイプを選択し、ASGを変更せずに迅速にスケーリングすることができます。結果として、ワークロードの変化に対してより速く、より効率的なスケーリングが可能になります。

2. インテリジェントなリソース統合: Karpenterはノードタイプの組み合わせを最適化することでコスト削減の機会を特定します。利用率の低いノードを終了させ、より効率的な代替手段に置き換えることでリソースを統合し、クラスターが各ノードを効果的に使用し、リソースの供給と需要を一致させて無駄を最小限に抑えます。

3. スポットインスタンスの最適化: Karpenterはスポットインスタンス(一時的な低コストVM)をクラスターにシームレスに統合します。コスト削減とスポットインスタンスの可用性の変動性のバランスを戦略的に取り、パフォーマンスと信頼性を維持しながらコスト効率よくリソースを拡張します。

Karpenterの合理化された自動化されたアプローチは、より速いスケーリング、より良いリソース利用、そしてより低いクラウドコストを提供し、動的なKubernetes環境のための強力なツールとなっています。

Kubernetesオートスケーリングのベストプラクティス

Kubernetesのオートスケーリングにおいて、効率的なリソース利用、パフォーマンス、コスト管理を確保するための5つのベストプラクティスを紹介します:

1. リソース使用率の監視と分析:

CPU、メモリ使用量、トラフィックパターンなどのアプリケーションパフォーマンスメトリクスを定期的に監視しましょう。このデータは、不要なリソース消費を避けながら最適なスケーリング動作を確保するために、オートスケーリングのしきい値を微調整する上で非常に重要です。

2. HPAとVPAポリシーの連携:

Horizontal Pod Autoscaler(HPA)とVertical Pod Autoscaler(VPA)が競合しないようにしましょう。HPAはポッドの数をスケールし、VPAは既存のポッドのリソース要求を調整します。連携が取れていないと予測不能なスケーリング動作を引き起こす可能性があります。適切な連携により、シームレスなスケーリングと最適なリソース割り当てが確保されます。

3. 混合インスタンス戦略の実装:

可用性を維持しながらコストを削減するために、インスタンスタイプの組み合わせ(例:スポットインスタンスとオンデマンドインスタンス)を使用しましょう。Cluster Autoscalerは、これらの多様なインスタンスが互換性のあるリソース容量を持っていれば効率的に管理でき、パフォーマンスを損なうことなくコスト削減を実現します。

4. 急速なスケーリングイベントの処理:

スケーリングポリシーを慎重に調整し、インフラストラクチャが急速なスケーリングをサポートできるようにすることで、需要の急増に備えましょう。適切なリソース制限、要求、クォータを設定することで、アプリケーションの安定性を損なうことなく、オートスケーリングが迅速に対応できるようになります。

5. カスタムメトリクスとサービスメッシュの活用:

オートスケーリングの判断を強化するために、カスタムメトリクスやIstioやEnvoyなどのサービスメッシュを活用しましょう。カスタムメトリクス(例:リクエストレートやレスポンスタイム)はより詳細な洞察を提供し、HPAが情報に基づいたスケーリング判断を行えるようにします。サービスメッシュは、ロードバランシング、リトライ、サーキットブレーキングを通じて回復力も追加します。

これらのプラクティスに従うことで、Kubernetes環境はスケーラブルで、コスト効率が良く、信頼性の高いアプリケーションデプロイメントを実現できます。

結論

このブログでは、Kubernetesをスケーリングする3つの方法:HPA、VPA、クラスターオートスケーリングについて見てきました。また、Kubernetesオートスケーリングのベストプラクティスについても説明しました。このブログは、初心者がKubernetesオートスケーリングの全体像を把握するための概要を提供しています。近い将来、このトピックについてさらに深く掘り下げ、より多くの洞察、ツール、実践方法を共有していく予定です。ご期待ください!